Kunstig intelligens fremkalder realistiske billeder af falske kendisser

Udtrykket "pics or it didn’t happen" bliver brugt i mere og mindre seriøse sammenhænge, når internettets diskussionslystne kræver bevis for et udsagn eller en begivenhed. Men det skal måske lægges i graven nu - eller i hvert fald skrives om.

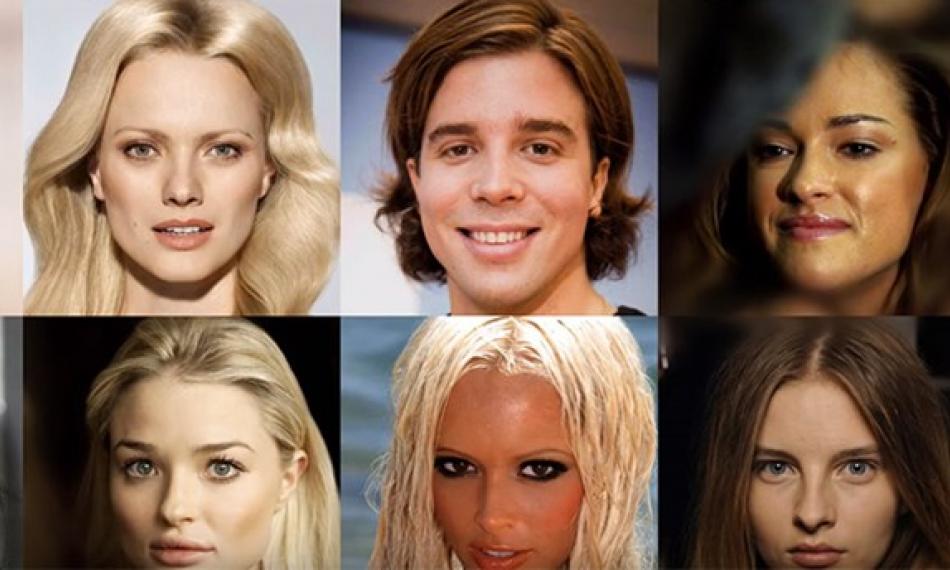

Software- og mikrochip-virksomheden Nvidia har haft held med at træne en kunstig intelligens til at kunne skabe billeder af for eksempel mennesker i forskellige situationer, som de færreste kan fælde på kvaliteten. Selvom billederne er det pure opspind.

Quartz vurderer, at potentialet for teknikken er stort - ikke mindst til kommercielle formål. Her vil den kunstige intelligens kunne skabe billeder med mennesker, der for eksempel skal bruges i en reklame. Men samtidig lurer faren for, at de forkerte vil tage værktøjet til sig.

Forestil dig at se Donald Trump erklære atomkrig mod Nordkorea i en video på Facebook. Eller se russiske tropper vade over grænsen til Baltikum i en video delt på Twitter. Eller se Lars Løkke Rasmussen opgive sin statsministerpost på Instagram.

To algoritmer og 30.000 kendisser

Teknikken fungerer ved, at to forskellige algoritmer konkurrerer mod hinanden. Den ene forsøger at genskabe et objekt eller en scene ud fra dens databank. Den anden algoritme forsøger at vurdere ægtheden. Når man fodrer denne kunstige intelligens med data, bliver den hurtigt klogere og mere præcis i gengivelsen af virkeligheden. Og det har ført til et gennembrud.

I forrige uge fremlagde Nvidia deres nyeste resultater. Forskerne har fodret en såkaldt supercomputer med 30.000 billeder af kendisser. De har med andre ord trænet den kunstige intelligens, og resultatet er bemærkelsesværdigt.

Nvidias teknik kan skabe billeder, der til forveksling ligner fotos fra dit eget album. Billederne er ikke i alle tilfælde helt perfekte. Nogle af dem viser kvinder med kun en ørering eller en hest med to hoveder.

Se selv med i videoen herunder.

Artiklen er produceret af Mandag Morgen for TjekDet